科技公司的为难战争:算法的“善意” 几乎毁了一位父亲的人生

- 科技

- 2022-08-24 11:55:27

在视频之前,护理让马克发一张相片给医师看下。马克照做了。

但是让他没想到的是,这张相片可给他惹了大祸了。

/ 爱子心切的父亲,算法眼中的“恋童癖” /

在相片宣告的两天后,马克忽然接到了Google的一纸告诉。

由于涉嫌贮存和传达有害内容,严峻违背用户协议和公司方针,并且涉嫌违法,他的Google账号被彻底封闭。

由于马克是Google全家桶的忠诚用户,Google这一决议的成果适当沉痛:

他不只失去了自己的 Gmail 邮件、通讯录、日历,还由于是 Google Fi 虚拟运营商的用户,连手机号都被一同冻结了。

到了这儿,噩梦还远未完毕。

Google不只封了他的账号,还直接把这件事签到专门冲击儿童色情/性虐待内容的监督组织那去了,该组织后来又联系了旧金山差人部分。总算在上一年年末,旧金山警方从Google公司那里调取了关于马克的一切材料和记载,正式对马克展开了查询。

长达一年的时刻里,马克面对“恋童癖”的严峻指控,作业日子都难以展开,乃至几乎“声名狼藉”……

《纽约时报》描绘此事的文章说到,将马克置于为难地步的,正是Google少为人知的儿童性虐待内容冲击体系。

依据美国政府的界说,儿童性虐待内容(Child Sexual Abuse Material,以下简称 CSAM),包含相片、视频等,只需其间触及未成年人显露色情行为的画面,都归于此类内容。更具体来说,触及包含拐骗、勒索、展现/煽动/宣传性化 (sexualization) 未成年人、拐卖儿童性质的内容,都归于Google明令禁止的 CSAM 范畴。

图片来历:Google

为了避免渠道、产品和技能被用于传达 CSAM,Google投入了许多资源,对 CSAM 进行扫描、阻挠、移除和告发——但是这次让马克遭殃的并不是Google的扫描技能,而是Google的人工查验流程出了遗漏。

在各大公司,CSAM 检索和过后告发的流程,都包含了算法扫描和人工查验的双保险准则,Google也不免俗。但是在马克的遭受傍边,在算法发现了相片,并自动触发体系锁死马克的账户,并交由人工查验之后,核查员好像并没有考虑其时的场景,没有发现这张相片是发给医疗专业人士的。

过后,马克当即进行了申述。但是Google不只回绝复核之前做出的决议,乃至都不让他下载保存自己的数据。被封闭的账号,数据在两个月后就被自动删除了,马克失去了曩昔多年堆集的许多重要信息。

作业就这样拖了整整一年,直到上一年年末警方正式启动了查询。

在这一年里,马克几近“社死”,很难跟搭档和朋友完好、诚实地解说,自己的电话号码、邮箱,为什么忽然就随便消失了。

直到本年前不久,当地警刚才完成了查询并予以结案。

成果毫无意外:马克无罪。

关于把自己的忠诚用户推动深渊,Google用法令作为盾牌的解说,很入情入理,却也绵软无力。一位公司发言人表明,美国的儿童维护相关法令要求像Google这样的公司有必要对发现的 CSAM 工作进行上报。

依据Google的透明度陈述,仅在2021年度,公司就屏蔽了近120万个触及 CSAM 的超链接,向美国相关监督组织“全国失踪与受虐儿童服务中心” (NCMEC) 提交了87万份陈述,触及约670万条内容,封闭了约27万个账号。

惋惜的是,马克不幸成为了27万分之一。

身处这27万人中心,就像那些进了监狱却高喊着无辜的人相同,那种有冤情说不出,说出也不被人信任的味道,几乎无法幻想。

/ 好意办坏事 /

在介绍冲击 CSAM 作业的官方页面上,Google声称,公司组成并训练了专门的部队,运用最顶级的技能来辨认 CSAM。

现在在美国大公司的规模里,检索 CSAM 有两种技能途径:哈希值匹配,和计算机视觉辨认。

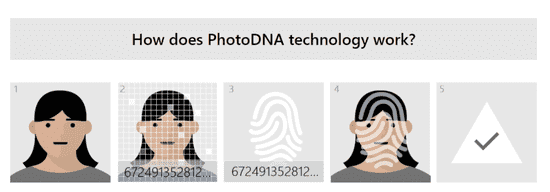

哈希值匹配比较简略,便是调取市面上第三方组织维护的数据库里的条目,和自己渠道上的图片进行哈希值匹配,然后检测已知的 CSAM 相关内容。这方面早年Google从前用过微软的 PhotoDNA。这项技能现已存在了10年多的时刻了,不止Google,包含 Meta、Reddit、Twitter 等公司,以及 CSAM 范畴的威望公共监督组织 NCMEC,都在运用它。

图片来历:微软

以及,Google系的 YouTube 也在运用自研的 CSAI Match 技能来,完成流媒体视频的哈希匹配。

当然,每天都有新的违法图片和视频诞生,所以除了哈希匹配之外,Google还自研并布置了依据计算机视觉技能的机器学习分类器,然后检索“未曾见过”的相关内容。

Google将这一技能整合到了 Content Safety API 傍边,也开放给第三方运用。现在,包含 Meta、Reddit、Adobe、yahoo等公司,也是Google自研 CSAM 检索技能的用户和合作伙伴。

图片来历:Google

至于本次案子,Google好像是从马克的 Google Photos 检索到了相关内容。

Google Photos 是Google推出的相片备份和云端相册服务,在自有品牌以及其它一些干流 Android 手机厂商的机型上都有预装。值得注意的是,用户在 Google Photos 里登录Google账号后,使用会提示主张用户翻开自动上传备份——马克或许便是在这儿吃了亏。

假如翻开了自动上传功用,除了在某些第三方使用(比方 Twitter、Instagram) 下载的相片之外,包含相机相片集,以及手机上生成的其它相片,都会被 Google Photos 会自动上传到云端。

而依据官方网站和公司发言人泄漏的状况,Google不止明令约束用户经过 Google Photos 上传和传达相关内容,它的 CSAM 冲击体系,也会对 Google Photos 里的相片进行扫描和匹配。

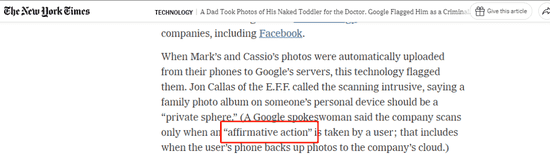

问题在于,依据Google发言人的表述,CSAM 冲击体系的目标仅限于用户“自动行为” (affirmative action) 上传的图片。

从务实的视点来看,马克敞开了 Google Photos 自动上传,成果由于急着给娃治病,拍了这张相片,自动上传了,忘了删,回头被Google找上费事——这样也要算作自动行为,不免有点勉强。

图片来历:《纽约时报》

扫描 CSAM,能够维护儿童安全,有效地冲击恋童癖和各种反常,听上去怎样都是一件功德对不对?

但是实际上,近年来美国大型互联网和科技公司在做这件事的时分各种问题毛病和丑闻不断——成果便是,算法自动化冲击 CSAM 这件事,在技能品德和隐私权方面现已引发了巨大争议。

假如把Google这次乌龙工作描述为“人祸”的话,那么上一年同一时刻苹果出的事端,能够称得上“天灾”了。

上一年8月初,苹果忽然宣告,将要在 iOS 渠道上推出一个专门扫描 CSAM 的客户端侧东西。

图片来历:苹果公司

苹果杰出的关键词在“端侧”上:和Google一直以来扫描云端服务器存储的用户内容的做法不同,苹果表明只会在用户设备上做这件事,体系会下载 NCMEC 的数据库,然后彻底在本地进行哈希值匹配。

但是,苹果所谓的“端侧”、“重视隐私”等,仅仅外表说辞。有专家发现,实际上用户发送到 iCloud 保存的相片也会成为检测目标。还有研究者发现苹果所选用的匹配算法 NeuralHash 存在规划理念缺点。并且这一技能底子不是行将推出,而是良久曾经就悄悄植入到揭露版 iOS 里了,苹果还专门混杂了 API 命名,以便“隐姓埋名”。

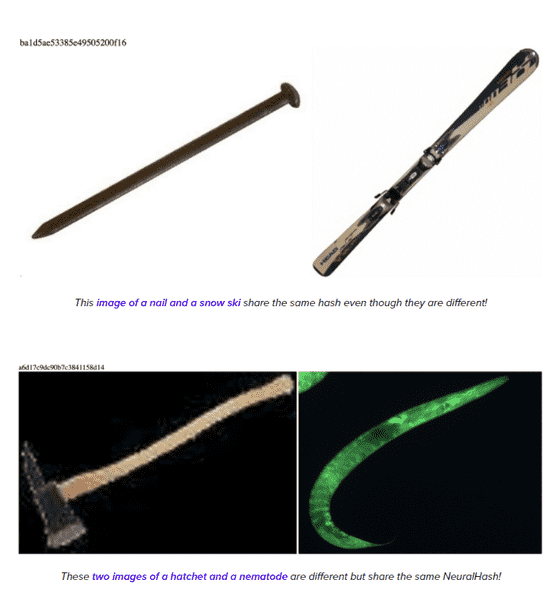

成果,苹果宣告了这件事之后没出一个月,就有人对 NeuralHash 算法完成了哈希磕碰和“原像进犯”。

简略来说,哈希磕碰便是找到两张哈希值相同的随机相片;而原像进犯,则是“故意生成的磕碰”,也即先给定一张相片,然后生成另一张和其哈希值相同,但内容不同的相片。

乃至,有人直接在广受欢迎的 ImageNet 标示图画数据库里,都能够找到几对天然的 NeuralHash “双胞胎”(两张不同的原视图片,哈希值相同)……

这些进犯测验的成果,从原理和逻辑上直接推翻了苹果的 CSAM 检索技能,使其一文不值。

图片来历:Cory Cornelius

前期测验的成果显现,NeuralHash 的哈希磕碰发生率和苹果声称的误报率水平差不多,归于能够承受的规模。但是考虑到苹果在全球具有超越15亿设备用户,基数过于巨大,一旦 NeuralHash 呈现误报,乃至哈希磕碰导致的事端,都会涉及许多用户。

总的来看,现在Google、苹果这两大移动渠道级超大型公司,在扫描和冲击儿童色情这件事上,都的确尽力做了一些作业,也值得鼓舞。

但是这件事的另一面,却令人大为惋惜:

由于一张顺手拍出的相片,作业和日子堕入僵局,乃至几乎声名狼藉,这恐怕是马克,以及不少和他阅历类似的人,所彻底没有预料到的。

这也是整件事的为难之处:在过界的科技渠道和糟糕的算法面前,好意真的或许会办坏事。

本文链接:https://www.yz0417.com/html/78383.html

发表评论